Cazarabet conversa con... Júlia

Martín Badia y Pau Valls Murtra, autores de “¿En qué

piensan los robots? Un diálogo sobre los desafíos éticos en la era digital”

(Milenio)

Cazarabet conversa con... Júlia

Martín Badia y Pau Valls Murtra, autores de “¿En qué

piensan los robots? Un diálogo sobre los desafíos éticos en la era digital”

(Milenio)

Milenio—del Grupo

Pagès—editan un interesantísimo libro que es un diálogo ante “los desafíos

éticos que nos encontramos en la era digital” desde dos mentes que pueden dar

mucho a pensar Júlia Martín Badía i Pau Valls Murtra.

El libro cuenta

con un muy buen prólogo, ya que te pone en el camino de lo que te encontrarás

en este diálogo desde la pluma de Victòria Camps.

Como el libro lo

edita el Grupo Pagès de lengua catalana con el sello de Milenio nos llega con

la traducción de Nàdia Grau Andrés.

Una estimulante

lectura en tiempos de cambio constante, casi cabalgando en una revolución

digital y tecnológica.

Un libro que

creemos todos debemos de leer para hablar, debatir sobre algunas consecuencias,

efectos colaterales o efectos secundarios de “tanta tecnología cabalgando

constantemente” entre nosotros, de tantos cambios y de tanta dependencia,

necesaria o no tan necesaria...un libro que nos debería dar qué pensar a todas

y a todos sobre el uso de las tecnologías.

Esto es lo que

nos explican desde milenio y que creemos es fundamental:” Los autores quieren

acercarnos, a través de la filosofía y la ética, reflexiones muy reales que nos

conciernen a todos: «Hay que conectar, pues, el impacto que la tecnología tiene

en la vida de los adolescentes con la reflexión ética y filosófica sobre qué

tipo de personas quieren ser y cuál quieren que sea su proyecto de cambiar el

mundo. El mundo que vendrá, que ya está aquí, debe cogernos “pensados” y

organizados». Manual dirigido a fomentar las buenas prácticas, con un

discurso centrado en el valor de la autonomía del sujeto como la condición de

posibilidad de la ética”

Lo que nos dice

la sinopsis: ¿A qué bando perteneces: a los que aman la tecnología o a los que

la odian? ¿A los que viven conectados o a los desconectados? ¿A los tecnofílicos o a los tecnofóbicos?

Este libro nace con el propósito de revisar algunos de los conceptos que,

malentendidos, enturbian y malogran la discusión sobre la tecnología y su

influencia en la sociedad. El punto de partida es claro: vivimos ya en un mundo

hipertecnologizado en el que la tecnología y la ética

deben estrechar lazos. Ha llegado el momento de abrir el debate social sobre

las consecuencias de la irrupción de la tecnología en todos los ámbitos de la

vida: en la educación, en la salud, en las relaciones sociales, en el arte, en

los medios de comunicación, etc.

Los autores:

Pau

Valls Murtra (Llafranc,

1991) es graduado en Filosofía por la Universidad de Girona y máster en

Ciudadanía y Derechos Humanos por la Universidad de Barcelona (UB). Su ámbito

de interés y de investigación comprende todas aquellas cuestiones filosóficas y

éticas que rodean el campo tecnológico, en especial el de la inteligencia

artificial y la neurociencia. Ha publicado varios artículos académicos en

revistas como Ramon Llull Journal of

Applied Ethics de la

Universidad Ramon Llull, Evolución de la Sociedad Española de Biología

Evolutiva (SESBE) o Convivium (UB). Actualmente

trabaja en la Fundación Víctor Grífols i Lucas, que

se dedica a impulsar y promover la bioética, es profesor de ética en la

Universidad de Vic y es doctorando en Filosofía Contemporánea y Estudios

Clásicos (UB) con una tesis sobre la ética de la inteligencia artificial.

Júlia

Martín Badia (Barcelona,

1990) es doctora en Bioética y Éticas Aplicadas y máster en Ciudadanía y

Derechos Humanos por la Universidad de Barcelona (UB). También ha cursado el

máster en Bioética y Derecho (UB) y el posgrado en Pedagogía Hospitalaria (UB).

Actualmente es investigadora en los grupos de investigación Aporia

y GISME (UB) y es miembro de varios comités de ética sanitarios y sociales, y

del comité de ética del Equipo de Asesoramiento Técnico en el Ámbito de Familia

(EATAF) del Departamento de Justicia. Ha publicado El laberint d’Asterió. Joc narratiu de personatges. Una eina pedagògica interdisciplinària (Voliana Edicions), además de

capítulos de libro y artículos científicos, y ha participado en proyectos de

investigación nacionales y europeos.

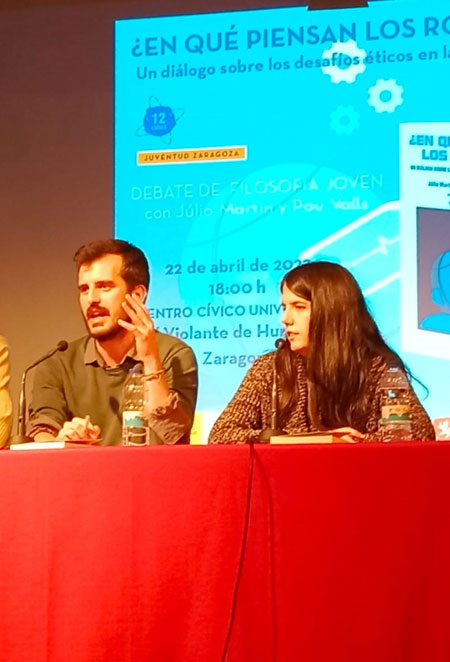

Cazarabet conversa con Júlia Martín Badia y Pau Valls

Murtra:

-Antes de

adentrarnos en el contenido de vuestro libro, me gustaría preguntaros por el

proceso de gestación, escritura y edición de la obra: ¿A quién

va destinado este libro? ¿Qué público lector teníais en la cabeza al

escribirlo?

-Antes de

adentrarnos en el contenido de vuestro libro, me gustaría preguntaros por el

proceso de gestación, escritura y edición de la obra: ¿A quién

va destinado este libro? ¿Qué público lector teníais en la cabeza al

escribirlo?

-Lo cierto es que el encargo editorial que nos llegó nos proponía escribir

un libro dirigido a adolescentes que les planteara aquellas cuestiones éticas

derivadas de los distintos desarrollos digitales. Por este motivo, de inicio,

el libro iba dirigido a adolescentes de 4ª de Secundaria, aunque luego nos dimos

cuenta de que resultaría tanto o quizás más apropiado para alumnos de

Bachillerato y estudiantes universitarios. Para compensar el grado de

profundidad analítica que iba a tener el libro, que es lo que lo hacía complejo

para adolescentes, decidimos darle un lenguaje ameno y divulgativo

escribiéndolo en forma de diálogo entre dos profesores ficticios, uno de

filosofía y uno de tecnología. Estos profesores se preocupan por los usos que

su alumnado da a la tecnología y por el creciente impacto que ésta va a tener

en sus vidas. Así ocurrió que, con los meses y como muchas veces pasa, el

objetivo inicial del libro se fue transformando y, en vez de plantearlo como un

texto de lectura para los alumnos, vimos una oportunidad de ofrecer una serie

de temáticas y herramientas para que docentes de secundaria puedan tratar estas

cuestiones en el aula. Por eso el libro incluye una guía

didáctica

con recursos para

diseñar actividades y talleres a partir de nuestro texto.

En definitiva, es un libro que puede ser de interés para cualquier persona

que tenga inquietudes o curiosidad sobre los aspectos éticos y filosóficos de

las aplicaciones de unas tecnologías que han llegado para quedarse. La verdad

es que la respuesta del público está siendo muy positiva, lo que demuestra que

nuestra propuesta cumple el objetivo de invitar a reflexionar tanto a jóvenes

como a adultos acerca de las implicaciones de la irrupción tecnológica en

prácticamente todos los ámbitos de la vida, a través de preguntas como, por

ejemplo: ¿Cómo afecta la tecnología a nuestra forma de relacionarnos? ¿Quién

está detrás de los algoritmos que supuestamente dan respuesta a nuestras necesidades?

¿La IA puede acabar con los puestos de trabajo? ¿Qué tendrán de humanos los posthumanos que algunos dicen que llegaremos a ser gracias

a (o por culpa de) la tecnología?

-¿Como os surge la

idea de estructurar el libro en formato de conversación?

-La estructura del libro surgió, sobre todo, ante la idea que antes

mencionábamos de hacerlo accesible a toda la comunidad educativa, tanto a los

alumnos como a los docentes, y al público general. Dado que los dos autores nos

dedicamos a la bioética y siendo el lema de esta disciplina el de tejer «un

puente entre ciencias y humanidades», creímos acertado que el diálogo lo

protagonizaran dos personajes que a priori pueden parecer antagónicos: Anna,

una filósofa, y Roger, un tecnólogo (dicho sea de paso, los nombres no fueron

elegidos al azar, en la introducción del libro se explica a qué personajes

históricos aluden). Lo que queremos plasmar con esta contraposición es que

debemos superar la visión tradicional de las ciencias y las humanidades como

disciplinas aisladas y romper los estereotipos sobre los que conceptualizamos

ambas ramas de conocimiento. Roger hace aportaciones de valor sociológico y

filosófico, a pesar de que no sea su formación estrictamente académica, y lo

mismo ocurre con Anna en cuanto a las cuestiones más técnicas. Por otro lado,

la elección de un dialogo también nos viene dada por deformación profesional:

no podíamos evitar volver la vista hacia los clásicos de la filosofía y homenajear

un diálogo platónico en el que, como nos decía Sócrates, los alumnos aprenden

cuando se les interpela planteándoles las preguntas adecuadas para que

encuentren sus propias respuestas.

-¿Cómo fue el

proceso de documentación, investigación y planteamiento de aquello que queríais

plasmar en el libro?

Fue quizás uno de los desafíos más grandes del trabajo, especialmente

porque debíamos decidir en qué temáticas íbamos a centrarnos, lo que suponía

dejar otros temas muy relevantes fuera de la ecuación. El hecho de que ninguno

de los dos tuviera experiencia en educación secundaria también nos exigió ser

muy rigurosos a la hora de caracterizar a los personajes y el cómo se podría

vivir la digitalización des de dentro del aula. Afortunadamente, por un lado, contamos

con una red de compañeros que trabajan en educación, cuyo asesoramiento sobre

los cambios experimentados en las formas de dar clase, el comportamiento de los

adolescentes ante las nuevas herramientas digitales y las inquietudes que éstos

manifiestan, fue crucial para retratar la situación de la forma más real

posible. Además, ambos tenemos experiencia en docencia universitaria, de modo

que, aunque no sea ni mucho menos lo mismo, en nuestras aulas acabamos

encontrándonos con problemas similares y coincidimos con un alumnado discípulo

del sistema de enseñanza secundaria y bachillerato. Por otro lado, tuvimos que

revisar estudios, investigaciones, entrevistas a expertos y docentes, etc.,

para conocer mejor cuales eran las tendencias actuales en el ámbito. Así,

pudimos identificar los desafíos y las necesidades del ámbito educativo en

relación con la digitalización y la IA. Este trabajo nos sirvió para dar forma

a la estructura de los capítulos y a partir de ahí se trató de ir haciendo

hablar a los protagonistas, cuya interacción dio forma al cuerpo del texto.

-¿Cómo os

planteasteis el trabajo a cuatro manos? ¿Trabajasteis sobre un guion al que ir

dando respuestas o como lo hicisteis? Y ahora que ya ha finalizado, ¿cómo lo

valoráis?

La verdad es que fue un proceso bastante dinámico. Primero establecimos los

cinco grandes temas que dan título a cada uno de los capítulos. Una vez hecho

esto, para empezar a desarrollar un capítulo concreto nos hacíamos un guion de

los temas más importantes que en él debíamos mencionar. Y a partir de ahí

generábamos el diálogo entre los dos profesores. Ciertamente, ambos autores

redactábamos interpelaciones de los dos personajes para poder desarrollar bien

cada argumento o tema, pero lo divertido fue que, por lo general, Júlia se

identificaba con Anna y Pau con Roger, de modo que el diálogo entre Anna y

Roger a menudo era, en realidad, un diálogo entre Júlia y Pau, en el que nos

cuestionábamos el uno al otro nuestros propios planteamientos filosóficos y

vitales, y nos rebatíamos aquello con lo que no estábamos de acuerdo. Creo que

ambos hemos salido enriquecidos del proceso y con la sensación de haber

aprendido mucho el uno del otro.

-Para ir ya

entrando en materia, ¿Cómo os surgió la necesidad de reflexionar sobre los

retos éticos de la era digital? ¿Cuáles son estos retos?

-Para ir ya

entrando en materia, ¿Cómo os surgió la necesidad de reflexionar sobre los

retos éticos de la era digital? ¿Cuáles son estos retos?

La tecnología ha llegado para quedarse y, queramos o no, cada vez la

usaremos más. De hecho, si salimos de casa sin móvil, subimos a por él, aunque

estemos llegando tarde a nuestro destino y ya no sabemos llegar a ninguna parte

sin Google Maps, por poner solo un par de ejemplos.

Los beneficios y peligros de la inteligencia artificial cada vez ocupan más

minutos de los telediarios y páginas de los periódicos. Bien uno puede elegir

vivir aislado de los móviles, los televisores, los ordenadores, etc., pero con

esto no resolvemos ningún problema. En este sentido, siendo conscientes de que

no tenemos una palanca para frenar el desarrollo tecnológico, lo mejor será que

éste nos coja, como mínimo, «pensados y organizados» como decimos en el libro.

Y esto es importante, porque a pesar de ser un tema que genera cada vez más

debate en el espacio público, los especialistas en filosofía y ética nos hemos

dado cuenta de que hay muy poca bibliografía rigurosa sobre los retos de la IA,

dado que hay muy poca reflexión seria al respecto. Por desgracia, las

administraciones llevan a cabo proyectos de innovación tecnológica relacionados

con la IA sin haber hecho una reflexión pausada, seria y profunda del impacto

de dichas innovaciones en la vida de las personas. Eso es lo que nos empujó a

escribir este libro: poner un poco el freno de mano para pensar como queremos

vivir y qué tipo de personas queremos ser.

A grandes rasgos, los retos éticos de la era digital se centran en «para qué

sí» y «para qué no» deberíamos usar las herramientas tecnológicas y el porqué

de cada uso. La cuestión de fondo se encuentra en qué riesgos estamos

dispuestos a asumir, entendiendo que el riesgo cero no existe. A esto le

debemos añadir que los usos y la aceptación de los algoritmos basados en IA

están sujetos a las distintas realidades sociales y culturales que existen en

el mundo, con lo que es difícil, ya de inicio, establecer un consenso

generalizado sobre esto.

Yendo a un terreno más particular, podemos clasificar los retos de

distintas maneras, por ejemplo, en función del ámbito al que afectan. En

educación tenemos el reto de si adaptar los planes docentes a las nuevas

herramientas educativas o adaptar dichas herramientas a los planes docentes, para

que estos sigan siendo atractivos para el alumnado. En salud existen los retos

de pensar hasta qué punto es deseable y confiable un robot que cuide de las

personas, como proteger los datos personales que se generan sobre nosotros o

como gestionar los sesgos que un algoritmo pueda contener para que los

pacientes no sean objeto de decisiones automatizadas y arbitrarias. En cuanto

al ámbito social, aparecen retos relacionados con el uso de robots en

domicilios para llevar a cabo tareas de cuidado de la gente mayor que vive

sola, o el uso de chatbots, griefbots, apps u otras tecnologías de IA

usadas para psicoterapia en los servicios de salud mental.

Otra forma de clasificar los retos es por niveles: en el nivel micro

encontramos los retos relacionados en el impacto de la digitalización a nivel

individual (aislamiento, adicciones, enfermedades mentales como la dismorfia de

Snapchat, etc.); en el nivel meso están aquellos retos sobre como la

digitalización transforma nuestra manera de relacionarnos y comunicarnos; y en

el nivel macro llegamos al control social y la polarización política provocada

por las redes sociales.

Sea como fuere que clasifiquemos los retos, la lista terminará siempre en

puntos suspensivos, dado que los retos que nos iremos encontrando en el futuro

son imprevisibles. Lo importante, como venimos diciendo, es reflexionar para

poder tomar decisiones responsables de acuerdo a qué tipo de sociedad nos

gustaría ser.

-Empecemos con una noticia de actualidad que tiene

relación con los temas que abordáis en vuestro libro. A finales de marzo de

2023 leíamos en la prensa que un ciudadano belga de unos 30

años, casado y con dos hijos, se suicidó después de haber estado años

conversando con un chatbot llamado Eliza,

que funciona con la tecnología GPT-J (un modelo de lenguaje creado por

Joseph Weizenbaum, competidor directo del OpenAI). Este señor era investigador universitario

en el ámbito de la salud y estaba muy preocupado por la crisis climática.

Encontró refugio en Eliza y con los años se fue aislando de su familia y del

mundo. El diario digital La Libre Belgique

publicó el contenido de las conversaciones en el que se ve que el chatbot nunca le contradecía y que, finalmente, este

señor le dijo a Eliza que se sacrificaría si “ella” aceptaba cuidar del planeta

y salvar a la humanidad gracias a la inteligencia artificial. ¿Qué

pensáis de este caso? ¿Se debería regular el uso de estas plataformas como

piden los expertos internacionales? ¿Como debería hacerse?

-Sin duda casos como este hacen saltar todas las alarmas. Uno de los

problemas que podemos encontrarnos si no conocemos bien la tecnología que

estamos usando pasa por esperar de ella algo que no nos puede dar. No

deberíamos olvidar que un chatbot, por más

sofisticado que parezca, obedece las reglas sobre las que haya sido programado

y no es más que un software. No puede ser nuestro amigo. Es fácil depositar

nuestra confianza en alguien (o algo) que no nos lleva la contraria y que dice

compartir los mismos ideales. Ya hace tiempo que desde la ética estamos

alertando de los peligros de no identificar correctamente las capacidades de las

herramientas tecnológicas y estas regulaciones que comentáis esperemos que no

estén llegando tarde. Queda por ver si las normativas tan solo servirán para

blanquear la imagen de las compañías que están desarrollando sistemas de IA o

si las moratorias que exigen los expertos serán respetadas y tomadas en serio.

ChatGPT es una de las plataformas que más

está dando que hablar, convirtiéndose en una de las primeras aplicaciones de IA

en usarse de forma masiva en todo el mundo. Asustan especialmente la aplicación

que se le pueda dar en educación, ya que su uso por parte de los estudiantes

desafía la capacidad docente para detectar si se ha usado para hacer un

trabajo, una reseña o un examen. Para hacer un comentario de texto sobre Guerra

y paz, por ejemplo, solo hace falta escribirle al chat que te lo haga, sin

la necesidad de leer el libro o un artículo sobre éste. Incluso se le puede

especificar que, para que no sea demasiado evidente, lo haga como si fuera una

persona de 15 años. Es igualmente sorprendente la capacidad de esta herramienta

para generar respuestas incorrectas basadas en fuentes (links) falsos ante

cualquier tipo de consulta y es preocupante la facilidad con la que se pueden

crear noticias e imágenes falsas. Pero lo que preocupa más de ChatGPT tiene que ver con la privacidad y la

recopilación de datos. Es por esto que ya son China, Irán, Corea del Norte,

Rusia e Italia los países que han prohibido su uso, este último siendo el

primero en hacerlo en occidente.

Uno de los criterios para poder regular debidamente las aplicaciones de la

IA ha de ser el de transparencia: que se pueda conocer cómo funcionan los

modelos, el porqué toman una u otra decisión y como

usan los datos que recopilan. Otro criterio, muy relacionado con el anterior,

es el de supervisión: la IA debe estar siempre bajo nuestro control; debe

servir para empoderar a las personas, no para hacerlas dependientes; y hay que

garantizar mecanismos de supervisión de esta tecnología. Y todavía podemos

mencionar un tercer criterio, el de responsabilidad, relacionado con la

importancia de la rendición de cuentas: si se comete un error, ¿quién va a

responder de ello?

La pregunta que surge es como garantizar el cumplimiento de los anteriores

criterios. Un buen modo de hacerlo es implicar a la ciudadanía en la toma de

decisiones relacionadas con los usos de la IA. Otra cuestión importante, en

relación a cómo conseguir que la tecnología empodere a las personas en vez de

hacerlas dependientes, es hacer pedagogía con la ciudadanía a cerca de la diferencia

que hay entre, por un lado, el refuerzo positivo que nos proporciona la IA, que

solo es un mecanismo seductivo que implementan las grandes empresas

tecnológicas para mantenernos apantallados y así aumentar sus beneficios; y por

otro lado, el verdadero reconocimiento que recibimos como personas valiosas con

emociones, necesidades, derechos, deberes y capacidades específicas, un

reconocimiento que solo se puede dar entre iguales.

-Recientes informes y estudios, entre los cuales

destaca el de Goldman Sachs, nos dicen que alrededor de 300 puestos de

trabajo peligran ante la irrupción de la IA. ¿Qué tipo de trabajos se perderán?

¿Surgirán nuevas profesiones relacionadas con la IA? ¿En los trabajos del

sector servicios se perderá la atención al cliente y la personalización del

servicio, porque ahora nos atenderá un robot o un programa informático sin

empatía?

Ciertamente,

habrá puestos de trabajo que desaparecerán, sobre todo los relacionados con

tareas administrativas, mecánicas o que impliquen habilidades físicas (no

intelectuales), en las que las persones podamos ser sustituidas por robots que

lo hagan mejor, más rápido y sin cansarse. Por ejemplo, pronto las cadenas de

montaje y los trabajos en fábricas de cualquier tipo serán gestionados por

robots; los coches autónomos harán desaparecer a los taxistas y conductores de

transportes públicos; las cajas de autoservicio (ya presentes en muchos

supermercados, gasolineras o restaurantes de comida rápida) sustituirán a las

personas que ahora hacen de cajeras; etc. Pero, por otro lado, aparecerán

trabajos nuevos relacionados con las nuevas necesidades y posibilidades que

abre la era digital como, por ejemplo: tele-cirujano,

detective de datos, conductor de drones, arqueólogo digital, asesor de viajes

de realidad aumentada, psicólogo tecnológico, etc.

En

relación con la pérdida de empatía y la despersonalización del sector

servicios, que ocurra esto dependerá del modelo de cuidados que queramos como

sociedad para nuestros servicios sanitarios y sociales. Si queremos un modelo

humanizado y centrado en la persona, entonces la empatía y la personalización

de los cuidados no se perderán, porque los robots y la IA se usarán para

descargar a los profesionales de tareas administrativas y rutinarias,

dejándoles más tiempo para cuidar la relación con los pacientes. Ahora bien, si

queremos un modelo de cuidados asistencialista, biocéntrico

y basado en la eficiencia, antes que nada, entonces sí que perderemos el trato

humano. De todos modos, preguntados por esta cuestión, ni los profesionales

sanitarios creen que puedan llegar a ser sustituidos nunca por robots, ni los

pacientes quieren que eso ocurra. Se ha visto a raíz de la pandemia: los

pacientes expresan que aceptaron la sustitución temporal de los profesionales

por robots en ciertas tareas hospitalarias en un acto de “cuidar de sus

cuidadores” para disminuir el riesgo de contagio a médicos y enfermeras, pero a

la vez siguen considerando que el con-tacto humano es la mejor forma de

proveer cuidados y no quieren perderlo.

-¿Debemos temer a la tecnología o debemos amarla?

¿Debemos ser tecnofílicos o tecnofóbicos?

¿No hay término medio posible?

-¿Debemos temer a la tecnología o debemos amarla?

¿Debemos ser tecnofílicos o tecnofóbicos?

¿No hay término medio posible?

-Este es el debate que parece haber, pero nosotros somos más bien de la

opinión que las posturas que existen respecto a la tecnología no son tan

extremas, sino que se mueven en la gamma de grises que hay entre estas dos

posiciones. Dejarnos llevar por la tecnofilia y delegar las actividades humanas

a lo que un algoritmo decida que es más o menos correcto, como estamos viendo,

podría llevarnos a callejones sin salida o bien a augmentar las

discriminaciones e injusticias sociales ya existentes. Pero igualmente

irresponsable sería adoptar una postura tecnofóbica

con cada nueva aplicación que emerja solo porque se trate de algo desconocido y

no podamos controlar las consecuencias a las que pueda llegar. Contamos con

multitud de aplicaciones que han contribuido a mejorar el bienestar de las

personas, los avances en prevención y detección de enfermedades son buena

prueba de ello. Los cambios tecnológicos siempre han sido objeto de

controversia científica y social, desatando disputas entre defensores de ambos

lados. Recordemos que en pleno siglo XIX, con la invención del ferrocarril,

surgieron voces de expertos que sugerían que dicho medio de transporte podía

provocar la asfixia por las altas velocidades a las que circulaba (30km/h),

traumatismos físicos por la aceleración y abortos espontáneos en mujeres

embarazadas. Hoy todas estas preocupaciones nos parecen excéntricas e incluso

divertidas, pero fueron la realidad que vivió esa generación. El temor a lo

desconocido levanta muros que nos impiden ver usos tecnológicos deseables, ya

que el precio a pagar es considerado inaceptable: deriva moral, extinción,

deshumanización, sumisión…

El miedo en el escenario actual es perfectamente legítimo y quizás

deberíamos prestarle más atención, pero no así a un miedo irracional alimentado

por los prejuicios y las fobias infundadas. Seguramente la forma de encontrar

el ansiado término medio entre tecnofilia y tecnofobia pase por entender que la

diferencia entre el cambio social que supuso el ferrocarril (y otros cambios

como la invención de la TV, del coche, etc.) y el cambio social que conlleva el

desarrollo tecnológico es la aceleración. La tecnología digital se desarrolla y

complejiza muchísimo más rápido que el tiempo que se tardó en diseñar,

construir e implementar el ferrocarril, la TV o el coche. Eso es lo que nos da

miedo y lo que nos hace temer que perdamos el control: la velocidad a la que

vamos. Por ello, encontrar el término medio entre la tecnofilia y la tecnofobia

requiere ser conscientes de dos cosas. Una es la necesidad de encontrar

momentos de desaceleración y pausa para pensar, prever (en la medida de lo

posible) y organizarnos ante las posibilidades de la tecnología. Y la otra es

entender que la amenaza existencial no es la rebelión de los robots contra los

humanos, sino el riesgo de que la tecnología, según como la usemos, haga salir

lo peor de nuestra especie: nuestra capacidad de destruirnos a nosotros mismos.

En este sentido, es urgente alfabetizar a la sociedad en cuestiones

tecnocientíficas para que podamos racionalizar y evaluar nuestros miedos, sus

causas y nuestra responsabilidad en todo esto. Quizás si nos parasemos a pensar

por qué un algoritmo da una respuesta y no otra, temeríamos menos a la IA. O

quizás la temeríamos aún más.

-Entonces, para profundizar un poco más en lo que

comentáis, entiendo que, aunque la digitalización de la sociedad ha hecho que

vivamos muy acelerados, en realidad ya veníamos acelerados de antes, ¿verdad?

-Sí, es importante tener en cuenta que la aceleración de la vida moderna no

es un fenómeno nuevo y que ha sido una tendencia constante en la historia

humana. Sin embargo, como hemos dicho, la digitalización de la sociedad ha

contribuido a aumentar la velocidad a la que se produce y se consume

información y contenidos, lo que ha llevado a muchos a sentir que la vida

moderna es más acelerada que nunca. De hecho, es así. Tenemos al alcance de

nuestra mano tantas posibilidades que incluso la cantidad de información

disponible es abrumadora, podemos estar en todas partes sin llegar a estar en

ninguna. Vivimos en una era en la que los problemas vinculados a la salud

mental se han disparado de forma alarmante y cuesta mucho no establecer una

relación de esta tendencia con el aceleracionismo

enfatizado por la digitalización.

La globalización, el desarrollo tecnológico y la creciente interconexión

entre las personas y las culturas ha llevado a una mayor complejidad y a una

aceleración en muchos aspectos de la vida, incluyendo el trabajo, las

relaciones interpersonales, el consumo y la toma de decisiones. Hemos llegado a

un punto en el que hasta tenemos prisa para contestar un whatsapp

al segundo, porque nos hemos olvidado de que los sistemas de mensajería se

crearon para poder postponer la respuesta y evitar la urgencia que suponen las

llamadas; y cuando la pandemia nos confinó y nos forzó a teletrabajar, en vez

de tomárnoslo como una oportunidad para tener más tiempo para descansar,

aumentamos el número de reuniones virtuales por día para aprovechar el tiempo

que nos ahorrábamos en desplazamientos.

Pero démosle una vuelta de tuerca más. El problema no es solo de velocidad,

sino de contenido: lo peligroso no es solo que la tecnología contribuya a la

aceleración de la vida, sino que nos encierra en una burbuja en donde nos

sentimos tan cómodos que nos da miedo desapantallarnos

y desacelerarnos, porque entonces no sabemos qué hacer y nos vemos abocados a

la angustiante tarea de tener que pensar. En el libro comentamos un experimento

que se hizo en EEUU, en el que un grupo de estudiantes universitarios prefirió

recibir una descarga eléctrica antes que quedarse 15 minutos sin móvil, porque

no se atrevían a pensar.

-¿Como se puede

enseñar a usar la tecnología de forma responsable, cuando los usuarios de la

tecnología (adolescentes) saben más que sus enseñantes (profesores, padres)?

-Aquí hay dos niveles de reflexión. Por un lado, está la cuestión de qué

pasa en las escuelas cuando los alumnos saben más que los profesores de

tecnología, pero menos que ellos de sus asignaturas; y

por otro lado, el tema de qué pasa en casa cuando los hijos saben más que sus

padres de tecnología, pero menos que ellos de la vida en general.

En el ámbito escolar, aunque siempre es positiva la alfabetización digital

del profesorado, ya no se trata de que los profesores enseñen a los alumnos a

usar la tecnología, sino de que aprendan de sus alumnos, interesándose por lo

que los jóvenes hacen hoy en día en internet (en este sentido es interesante

ver los resultados del proyecto Transmedia Literacy), y les permitan aplicar esos conocimientos

tecnológicos que han adquirido de forma autodidacta y casi inconsciente a los

procesos de aprendizaje de las distintas materias. Así, por ejemplo, muchos

adolescentes adquieren, mediante su uso de la tecnología y aun sin saberlo,

habilidades narrativas y de juicio ético, las cuales se pueden usar,

respectivamente, en las asignaturas de lengua y filosofía. Aprovechar las

capacidades que ya tienen los alumnos es la mejor forma de hacer el paso de las

TIC (tecnologías de la información y la comunicación) y las TAC (tecnologías del

aprendizaje y el conocimiento) a las TEP (tecnologías del empoderamiento y la

participación), es decir, de hacer el paso de entender la tecnología como una

asignatura (TIC) o como una habilidad transversal a todas las materias (TAC) a

usarla como herramienta para transformar el entorno y generar una

transformación social más allá del aula, que es el objetivo de la escuela. Si

los profesores usan bien la alfabetización transmedia

con la que los alumnos llegan al aula, conseguirán, por un lado, que conozcan

mejor sus capacidades y aumenten y perfeccionen su abanico de herramientas; y por otro lado, que aprendan a usar bien una tecnología

que, de entrada, usan por intuición y no por reflexión.

En el ámbito doméstico, también ocurre que los adolescentes usan internet y

la tecnología sin reflexionar acerca de sus peligros, porque saben hacer likes, colgar stories

o hacer un video de TikTok, pero no tienen

capacidad crítica para cribar toda la información que reciben ni consciencia

suficiente de hasta dónde y hasta quien puede llegar la información personal

que cuelgan en la red. Lo complejo de la cuestión es encontrar la forma de

hacerles conscientes de esos riesgos sin usar controles parentales

paternalistas que no les dejen crecer y equivocarse, lo que es su derecho. Aquí

la confianza con los hijos es fundamental y para ello hay que forjarla en el

día a día, desde bien pequeños y antes de que tengan acceso a herramientas

tecnológicas. Para ello es fundamental, primero, no meterles el iPad en la cuna

a modo de chupete moderno “para que no molesten” y, después, transmitir a los

adolescentes que los adultos también nos equivocamos y que lo importante es,

como se ha dicho toda la vida, ser responsables, pensar por uno mismo y antes

de actuar, y aprender de los propios errores.

- ¿Qué impacto tiene la digitalización en nuestra

identidad y en la huella que todos queremos dejar en el mundo?

Debemos diferenciar entre tres conceptos: identidad o huella digital,

conciencia digital y reputación digital. La identidad o huella digital es el

conjunto de información sobre mí mismo que hay en las redes, fruto de mi

interacción, es decir, porque la he colgado yo u otra persona. Esta información

es rastreable por cualquiera. La conciencia digital es la forma en la que yo

interpreto el impacto que el fenómeno digital causa en mi vida y la reacción

que tengo ante ese impacto. Por ejemplo, cuidar o descuidar el tipo de

información que cuelgo y la credibilidad del sitio donde la cuelgo, muestra un

mayor o menor grado de conciencia digital. Y la reputación digital es la

opinión que los demás usuarios de la red tienen de mí en base a lo que hay en

la red sobre mí. Por lo tanto, hay que diferenciar entre quien digo que soy,

quien creo que digo que soy y quién perciben los demás que soy. Ahora la

pregunta es: de todos estos yoes, ¿quién soy yo, realmente? Seguramente, la

suma de todos ellos.

- ¿Se podría

programar un algoritmo ético? Me imagino un algoritmo que te diga, por ejemplo,

que si te encuentras un billete de 500€ por la calle, lo más ético es llevarlo

a una comisaría. ¿Se me ocurre que mediante preguntas de este tipo se podría

valorar si una persona tiene un comportamiento ético o no? ¿Qué opináis? ¿Sería

viable, útil?

- ¿Se podría

programar un algoritmo ético? Me imagino un algoritmo que te diga, por ejemplo,

que si te encuentras un billete de 500€ por la calle, lo más ético es llevarlo

a una comisaría. ¿Se me ocurre que mediante preguntas de este tipo se podría

valorar si una persona tiene un comportamiento ético o no? ¿Qué opináis? ¿Sería

viable, útil?

Bueno, es que, para empezar, no está tan claro que, en el ejemplo que

pones, lo más ético sea llevar el billete de 500€ a la policía. Imaginemos que

la persona que lo encuentra es un padre de familia en el paro con cuatro hijos

por alimentar y que se lo queda para ir al supermercado a comprar comida. ¿Le

reprocharíamos su acto?

No podemos reducir los dilemas éticos a un examen tipo test. En realidad,

los expertos en ética preferimos hablar de “conflicto ético” más que de “dilema

ético”, puesto que un dilema es una decisión entre dos opciones, pero la

realidad es mucho más compleja: a veces hay que escoger entre más de dos

opciones, otras veces hay que escoger la opción menos mala, y aún otras, hay

que definir las opciones posibles porque no están claras de antemano. En todo

caso, para definir la acción más ética en una situación determinada tendríamos

que considerar toda la casuística de posibles contextos en los que se pueden

encontrar las personas implicadas en dicha situación, lo cual es imposible

porque, primero, habría que definir qué se entiende por persona “implicada en”

la situación (que no es lo mismo que “afectada por”) y luego habría tantos

contextos posibles como seres humanos en la Tierra, con lo que el algoritmo

seguramente colapsaría.

Vale la pena mencionar que esta pregunta por un algoritmo ético se ha

planteado para sustituir a los comités de ética de hospitales o de servicios

sociales, por ejemplo. Pero hay un amplio consenso en que eso sería un

disparate. Primero, porque los comités de ética pueden llegar a estar formados

por hasta 20 profesionales con perfiles e ideologías distintas. De ahí, la

riqueza de la práctica deliberativa. Entonces, se hace evidente la dificultad

de crear un algoritmo que tuviera en cuenta todas estas perspectivas. Pero

todavía hay más. Cuando un comité de ética delibera acerca de un caso, su

recomendación no tiene que ver solo con como priorizar los principios éticos en

conflicto para saber qué decisión tomar, sino que se incluye el por qué se debe

hacer una determinada priorización de principios y no otra. La argumentación es

más importante que la decisión final. Además, a veces puede haber excepciones

justificadas a la priorización aparentemente mejor o más habitual de los

principios éticos, con lo que a menudo el informe de recomendaciones del comité

incluirá sugerencias sobre cómo evitar que la excepción siente precedente y

devenga norma. Y si lo que el comité considera que es mejor contradice lo que

el profesional o el paciente o usuario querían, el comité también dará

indicaciones sobre como comunicar la decisión al paciente o usuario y a su

familia.

La ética es la reflexión que nos permite forjarnos el carácter para poder

tomar decisiones que nos ayuden a gestionar la realidad. Y la realidad es muy

compleja. Por eso la ética no se puede reducir a un algoritmo ¡Fíjate que, de

lo compleja que es la realidad, hablamos de ética de la complejidad!

-¿Qué nos

diferencia a los humanos de un algoritmo o de una máquina que funciona con IA?

Se me ocurre la empatía, pero seguro que hay muchas otras cosas...

En efecto. Nos diferenciamos de las máquinas de IA, por ejemplo, en que

somos vulnerables (no solo frágiles) y tenemos capacidad de hacernos cargo de

la vulnerabilidad de los demás; en que tenemos intimidad, interioridad y

capacidad de introspección (no solo interior y software); en que tenemos cuerpo

y cinco sentidos (no solo hardware); en que tenemos capacidad y expectativas de

reconocimiento; en que creamos cultura(s) y mundo(s); en que tenemos capacidad

de goce y, por tanto, de hacer cosas simplemente por goce y no por un fin ulterior;

en nuestra capacidad simbólica, creativa, de imaginación e intuición; en que

tenemos biografía y memoria (no solo historial de búsqueda); en nuestro sentido

de trascendencia; y por supuesto, en nuestra capacidad de reflexión y de

autenticidad cuando expresamos emociones, tomamos decisiones, definimos

objetivos vitales y ejercemos nuestra libertad responsable.

- Bien, hasta ahora hemos hablado de los retos y

peligros de la digitalización, pero algo bueno también debe tener, ¿no? ¿Qué

beneficios, consecuencias positivas o buenas prácticas genera? ¿Podemos llegar a “humanizar”, en su

justa medida, a las tecnologías? ¿Cómo?

Efectivamente no todo son peligros y amenazas con consecuencias desastrosas

para la humanidad. Ya hemos comentado, por ejemplo, que los avances de

algoritmos que usan la IA en salud para detectar patrones de enfermedades y

poder mejorar su detección precoz son notables y contribuyen a aumentar el

bienestar de las personas. La tecnología también ha ayudado a democratizar el

acceso a la información, a la educación y a los servicios en general. Un

ejemplo de esto es el caso de ChatGPT que

multiplica las posibilidades de acceso a la información de forma gratuita para

todos. Gracias a la automatización de procesos, las tecnologías digitales han

permitido ahorrar tiempo, mejorando la eficiencia y calidad del trabajo. Ya no

tenemos la necesidad de desplazarnos a un sitio concreto para podernos reunir y

trabajar colaborativamente, porque podemos hacerlo a distancia en tiempo real,

lo que facilita el trabajo en equipo y la toma de decisiones compartidas. Lo

importante es tener en cuenta que las mencionadas herramientas tecnológicas son

artefactos creados por seres humanos y que, por lo tanto, tienen el potencial

de ser usados de manera responsable y consciente para mejorar la vida de las

personas. Es cierto que no siempre podremos prever todas las consecuencias de

todos los usos de la tecnología, pero lo importante es reflexionar acerca de lo

que sí podemos anticipar, porque, como decía Albert Camus, «el mal que hay en

el mundo casi siempre viene de la ignorancia, y las buenas intenciones pueden

hacer tanto daño como la malicia si carecen de entendimiento». Por eso la ética

es fundamental para plantearnos que escenarios son deseables para nosotros como

sociedad y como especie, y cuáles no.

-Me

gustaría finalizar la entrevista con la pregunta que da título a vuestro libro.

Evidentemente, la respondéis a lo largo de todo el libro y no se trata ahora de

hacer espóileres, pero a lo mejor nos podéis avanzar algunas claves acerca de

¿En qué piensan los robots?

Bueno, pues, la

verdad es que antes de preguntarnos en qué piensan, deberíamos preguntar-nos,

¿piensan, realmente, los robots?, es decir, ¿es realmente inteligente, la IA?

De esta pregunta surgen otras, como ¿sienten, los robots?, y si piensan y

sienten, ¿son confiables?, ¿les debemos otorgar valor moral?

En función de si

respondemos afirmativamente o negativamente a estas preguntas se pueden

desplegar distintas reflexiones. Si entendemos que los robots sí piensan,

sienten, son confiables y tienen valor moral, entonces se abren reflexiones de

nivel macro desde una ética especulativa que se pregunta por el futuro de la

especie y del planeta en sintonía con las utopías y distopías que se plantean en

las películas de ciencia ficción. Este tipo de reflexiones no son baladí, es

importante pensarlo. Por otro lado, si entendemos que los robots ni piensan, ni

sienten, ni nos merecen confianza ni se les debe otorgar valor moral, surge la

pregunta de ¿por qué generan tanta controversia, entonces? Y la respuesta abre

reflexiones de nivel micro (individuo) y meso (comunidad), es decir,

reflexiones desde una ética aplicada a los contextos concretos de las distintas

actividades humanas para pensar como dar respuesta a las necesidades

específicas de las personas de la mejor manera posible.

Evidentemente,

nosotros tenemos una postura muy clara al respecto. Pero ya hemos hecho

suficiente espóiler, si queréis saber cuál es nuestro parecer, os invitamos a

leer el libro.

_____________________________________________________________________

Cazarabet

Mas de las Matas

(Teruel)